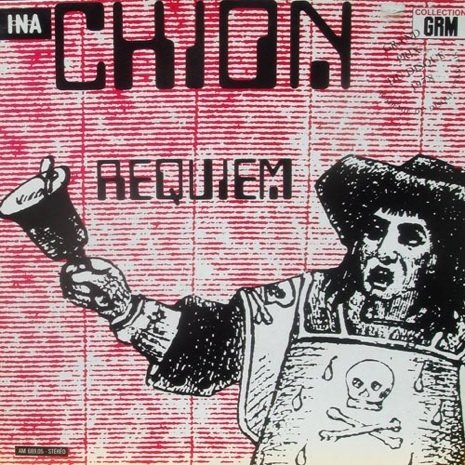

Il Requiem elettroacustico di Michel Chion è del 1973 (non 1993 come riporta erroneamente il video su You Tube qui sotto).

Il Requiem elettroacustico di Michel Chion è del 1973 (non 1993 come riporta erroneamente il video su You Tube qui sotto).

Quando l’ho ascoltato (sarà stato il 1977/78), mi ha fatto una notevole impressione. È un lavoro che ridefinisce completamente i canoni della musica concreta francese. Li supera con l’uso massiccio di sonorità puramente elettroniche a cui sono accostati suoni naturali, loop concreti e frammenti musicali, spesso trattati elettronicamente in modo evidente, ma soprattutto voci recitanti con modalità fra loro diverse: intense, sussurrate, urlanti, lontane, in coro, fino a una voce di bambino che legge, con qualche esitazione, una parte del testo.

È un’opera drammatica e intensa, emozionale, che va molto al di là del puro esercizio compositivo.

Note dell’autore:

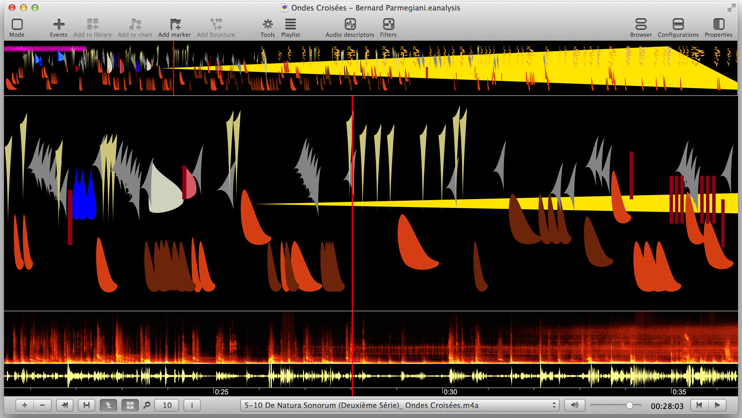

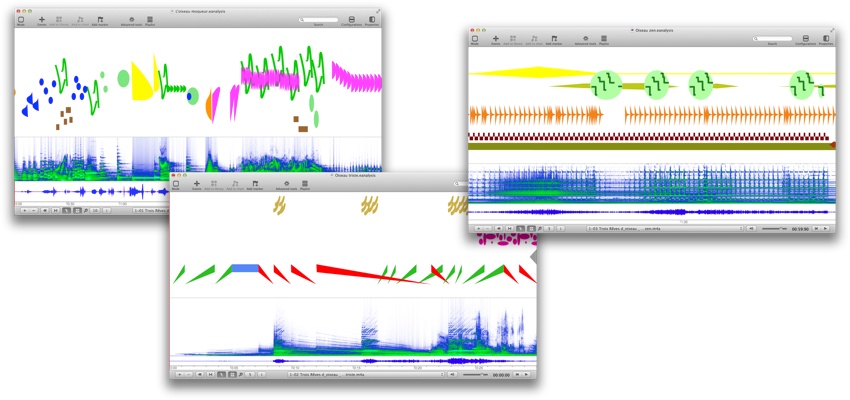

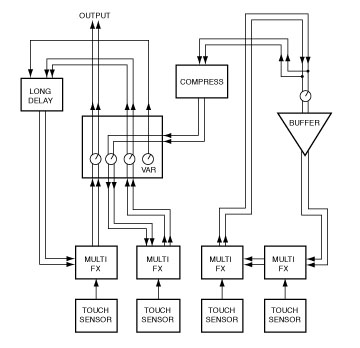

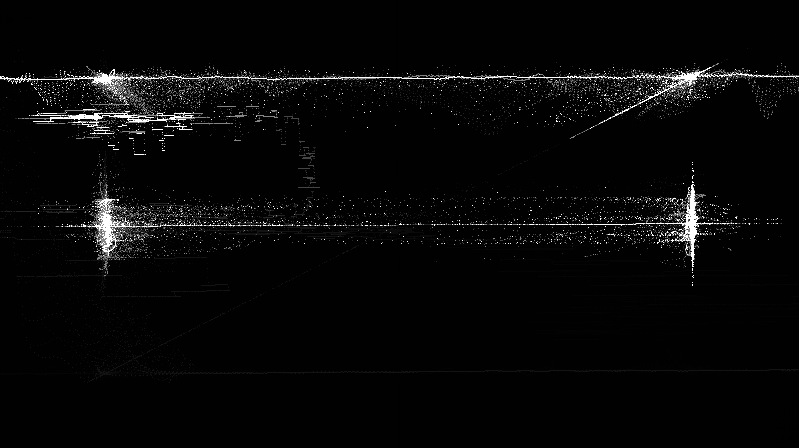

The Form of this music was not meant as an excuse to deploy refined geometry over a time frame seen as space. And if Requiem as a whole is built on a system of echoes and correspondences that seem to be symmetrically organized (see graphism) around an axis represented by the work’s middle point, it is not my fault. The form was developed in the course of the process, as a dramatic scheme that played off the listener’s memory and premonitions, since once the listener has heard the work more than once, they can predict as well as recall. The musical analysis I came to perform, and of which I am disclosing a few pieces here, I did long after composing the work and for my own enjoyment. It should be understood as a game, not as the Key of Dreams, and it is surely not essential.

Echoes and correspondences of what ? Themes, musical motives, ranging from the most elemental (a loop, raw matter) to the most elaborated (a musical development), and which are reprised, quoted or announced at various moments of the work – some are easily identifiable as “leitmotivs” (theme-chorus from the Dies Irae quoted in the finale), while others are accompanying motives, matter that does not need to be memorized at a conscious level. An extreme case of such echo effect is found in the short movements 2 & 9, which use almost the same “music” cast under completely opposite sound lighting.

The centre of the work, the axis of that symmetry, is the 6th movement (Evangile), where happens a symbolical tear in the magnetic tape, a crack in the work itself, opening in the timeline a breach of eternity that lets us glimpse “something else.” This figure illustrates that breach as a sawtooh line, while the vertical line illustrates the pasted point, the moment (at the beginning of Sanctus) when the mass itself, like a broken reel of film at the cinema show, resumes. Within this large form in two parts, we find the small forms of each movement: forms with choruses and episodes, litanies, recitativo, levelled crescendos, etc. There is also another formal course delineated by the succession of several vocal characters, their timbre, intonation, and relation to the libretto. Without giving more details, it is worth mentioning that the only time a well-assured, peremptory voice is clearly heard is, once again, at that central moment in Evangile (“il va ressusciter” or “he will rise”), where its irruption seems to spread panic throughout the whole system and provoke the breach…

Like the great requiems of the classical era, this Requiem’s text is taken from the Funeral Mass, to which are added an Epistle, a Gospel and a Pater Noster. The texts are mostly said in their original language (Latin or Greek) and in French, in some rare cases.

The Requiem was composed whilst thinking about the troubled minority of the living, rather than the silent majority of the dead. Also, I tried to turn this oratorio into a “great sonic show,” cinemascope music. One can detect the obvious (at least to me) influence of a few filmmakers and films, more in the way of playing with forms, time and space, than through realistic evocations. Thomas Mann’s Docteur Faustus was another influence, again acknowledged after the fact; the pages spent describing the imaginary works of Adrian Leverkühn might have inspired the megalomaniac dream of carrying bits and pieces of them into the sound world. With Requiem, my intention was not to deliver a message or a manifesto, whether pro- or anti-religious. Instead, this work is a personal testimony, into which listeners are invited to project their own self, if they care to inhabit it with their own experience and sensibility.